Was sind Bits?

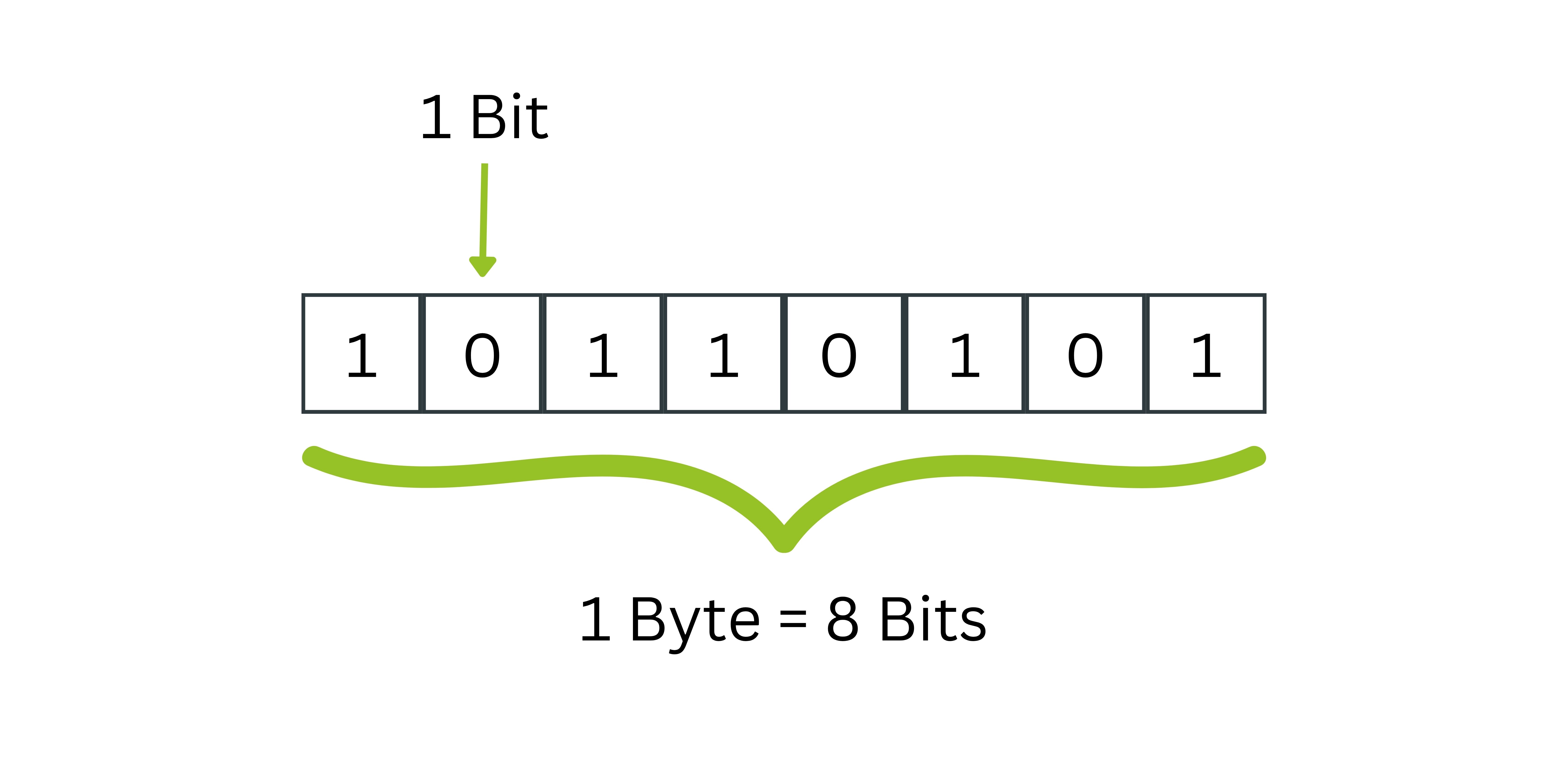

Bit leitet sich aus dem englischen Begriff „Binary Digit“, was übersetzt „Binärziffer“ bedeutet. Das Bit bildet die kleinste Informationseinheit, um Daten in einem Binärcode darzustellen und kann mit dem Einheitenzeichen „b“ abgekürzt werden. Diese Binärziffer kann zwei verschiedene Ausprägungen annehmen:

- 0: häufig bezeichnet als „false", „falsch" oder „nein"

- 1: häufig bezeichnet als „true", „wahr" oder „ja"

Um Zahlen, Buchstaben oder andere Schriftzeichen zu kodieren, können mehrere Bits zu einer Bitfolge wie dem Byte zusammengefasst werden. Dieses besteht aus acht Bits und kann somit 256 unterschiedliche Zustände annehmen.

Die Verwendung von Bit und der Unterschied zu Bytes

Während Bytes bei der Verwendung von Speicherkapazitäten gebräuchlich sind, werden Bits bei Datenverbrauch oder Übertragungsgeschwindigkeiten, zum Beispiel im Internet, verwendet. In diesem Fall beschreibt die Bitrate, wie viele Dateneinheiten beziehungsweise Bits pro Sekunde übertragen werden.

Bits und Bytes in der digitalen Welt

Im Computer bildet der Begriff Bit die Grundlage jeder Datenverarbeitung und Datenspeicherung. Während ein einzelnes Bit nur zwei verschiedene Zustände 0 oder 1 in der binären Logik annehmen kann, werden durch die Kombination von 8 Bits zu einem 8 Bit umfassenden Byte bereits 256 Zustände dargestellt. Diese binäre Struktur aus Bits und Bytes ermöglicht es modernen Speichermedien wie der Festplatte oder USB-Sticks, enorme Datenmengen zu verarbeiten. Die Kapazität solcher Medien wird in standardisierten Maßeinheiten angegeben: vom Kilobyte (KB) über Megabit (Mbit) bis hin zum Gigabyte (GB) oder höher. Während das Byte die Standardeinheit für die Datenmenge auf Speichermedien darstellt, spielt das Bit besonders bei der Übertragung von Daten eine zentrale Rolle, etwa bei der Messung von Internetgeschwindigkeiten, wo Megabit pro Sekunde die gängige Einheit bilden. Die binären Strukturen sind somit das Fundament für die gesamte digitale Infrastruktur.

Vom Bit zum Byte: Grundlagen der Informatik

Da das 1 Bit als kleinste Einheit genau zwei Zustände 0 und 1 annehmen kann, bildet es damit die Basis für alle größeren Dateneinheiten in der Informatik. Der Begriff "Binary Digit" wurde erstmals 1948 in Claude Shannons wegweisender Arbeit "A Mathematical Theory of Communication" als Maßeinheit für den Informationsgehalt etabliert und wird seither in der Nachrichtentechnik sowie verwandten Fachgebieten vielfach verwendet. Die Verwendung von Bits bilden einen fundamentalen Baustein für komplexe Daten und Anweisungen. Die Umrechnung zwischen Bits oder Bytes folgt klaren Standards: 16 Bit entsprechen 2 Byte, während 256 Bits in 32 Bytes umgerechnet werden. Bei der Datenrate wird die Geschwindigkeit in Bit pro Sekunde gemessen, wobei viele Bits übertragen werden müssen, um größeren Dateneinheiten gerecht zu werden. Die IEC hat standardisierte Maßeinheiten für Datenmengen definiert, die zeigen, wie Bits dargestellt und in Bytes erklärt werden. Im Vergleich Bit vs Byte wird deutlich: Bit und Byte arbeiten zusammen, um binäre Zahlen und Binärzahlen zu kodieren, wobei jedes Bit verschiedene Zustände darstellen kann. Die Anzahl der Bits bestimmt letztlich, wie präzise genau zwei Grundwerte das "Bit" mit seinen 0 und 1 zu komplexen Informationen kombiniert werden können.